Что вам нужно знать о robots.txt и инструментах для его проверки? Рассказываем в подробностях

Содержание

Впервые о файле robots.txt (его ещё называют индексным) услышали в 1994 году. За 26 лет его существования изменилось многое, кроме одного – большинство владельцев сайтов до сих пор ничего о нём не знают. Почему стоит познакомиться с robots.txt вашего сайта? Почему так важна его грамотная настройка? Какие ошибки обычно возникают при работе с robots.txt? И как понять, что в файл пора вносить правки? Давайте разбираться.

Что такое Robots.txt и зачем он нужен?

Robots.txt по праву можно назвать помощником поисковых роботов. Этот файл подсказываем им, какие разделы есть на сайте, какие страницы стоит посмотреть, а на какие заглядывать нет никакой необходимости. Именно в этом файле прописывается запрет индексации на технические страницы, дубли и страницы, которые вы по каким-то причинам не хотите показывать великим и ужасным поисковым системам — Яндексу и Google. Содержимое индексного файла прописывается при помощи кодировки UTF-8. Использование другой кодировки может стать причиной неправильной обработки информации поисковыми роботами.

В рамках SEO файл robots.txt тщательно анализируют с помощью инструментов для его проверки. Почему это так важно? Потому что всего одна ошибка в содержимом этого помощника поисковых роботов может стоить вам бюджета продвижения. Заглянем внутрь этого файла и изучим его подробнее.

Из чего же, из чего же сделан robots.txt?

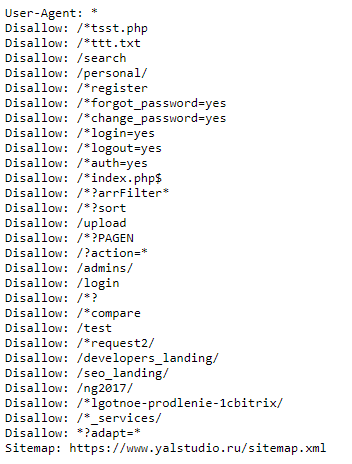

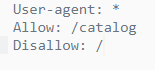

Чтобы изучить индексный файл своего сайта, откройте его. Для этого зайдите на главную страницу своего ресурса, в адресной строке после адреса сайта поставьте слэш, а затем введите название файла, который вам нужен (robots.txt). Загрузите страницу. Перед вами тот самый индексный файл. Первая часть нашего robots.txt выглядит вот так:

Ваш robots.txt сильно отличается? Не спешите расстраиваться.

User-agent

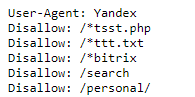

Если напротив User-agent в вашем индексном файле прописан Googlebot или Yandex, значит правила задаются только для указанного робота. Звездочка, использованная в примере ниже, показывает, что правила действуют для всех поисковых роботов без исключения. Ошибки в этом правиле можно найти и без инструмента для проверки файла robots.txt.

Disallow

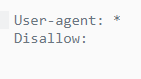

Если на сайте нет страниц, которые нужно закрывать от сканирования, robots.txt может выглядеть вот так:

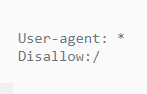

Если сайт полностью закрыт от индексации, то запись будет отличаться всего на один символ:

Вроде мелочь, а для роботов поисковых систем — совершенно другая картина. Если разработчик закрыл от индексации только часть контента (например, папку, отдельный URL или файл), это отображается напротив правила Disallow.

Allow

Тогда как предыдущее правило запрещает индексирование определенного контента, то это, наоборот, разрешает. Когда его использовать? Например, вы хотите показывать только те страницы, которые располагаются в разделе «Каталог». Все остальные страницы в таком случае закрываются от индексации с помощью правила Disallow.

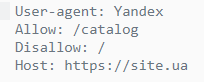

Host

Это правило используется для показа роботу главного зеркала сайта, которое нужно индексировать. Если сайт работает на HTTPS, протокол обязательно прописывается в индексном файле. Если на HTTP, название протокола можно опустить. Выяснить, верно ли прописано это правило на вашем сайте, можно и не используя инструмент для проверки файла robots.txt. Достаточно найти строку со словом host и сравнить её с образцом.

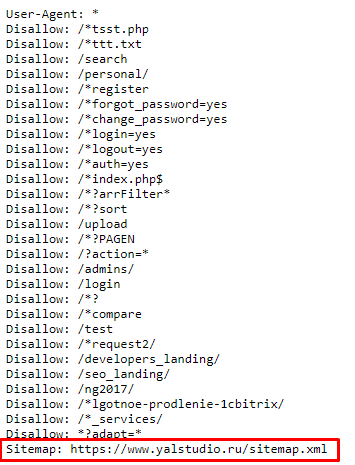

Sitemap

С помощью этого правила вы показываете роботам поисковых систем, где можно посмотреть все урлы вашего сайта, которые он должен проиндексировать. Чтобы их найти, роботу придётся прогуляться по адресу типа https://site.ua/sitemap.xml. Всё это вписывается в индексный файл. У нас это сделано вот так:

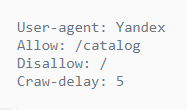

Crawl-delay

Правило стоит использовать, если у вашего ресурса слабый сервер. Оно позволяет увеличивать длину промежутка загрузки страниц. Параметр по умолчанию измеряется в секундах.

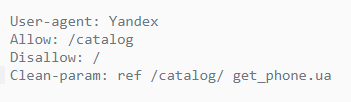

Clean-param

Это правило призвано бороться с дублированием контента, связанным с динамическими параметрами. Из-за сортировок, разных id сессий и других причин на сайте одна и та же страница может быть доступна по нескольким адресам. Чтобы поисковый робот не расценил такое явление как дублирование, его прописывают в robots.txt. Если страница отвечает по адресам:

,

то правило выглядит следующим образом:

Прежде чем познакомиться с инструментами для проверки файла robots.txt рассмотрим символы, применяемыми в нем.

Не правилами едиными…

Чаще всего в robots.txt используются следующие символы:

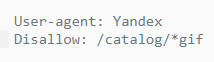

- Звездочка

Необходима для обозначения любой последовательности. Например, с её помощью можно спрятать от робота все файлы с расширением gif, хранящиеся в папке catalog. - Слэш

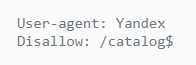

Ставится для обозначения местонахождения файла в корневом каталоге, а также в тех случаях, когда нужно закрывать от индексации весь сайт. - Знак доллара

Этот символ показывает, где перестает действовать звездочка. В примере на скриншоте мы закрываем от индексации содержимое папки каталог, но при этом урлы, в которых содержится элемент catalog, индексировать разрешено. - Решётка

Используется значительно реже, чем все остальные символы, потому как нужна только для комментариев. После решётки можно написать любую подсказку, которая поможет в работе вам или веб-мастеру, работающему с сайтом.

Чем проверить robots.txt?

В интернете можно найти добрую сотню сервисов, разбирающих по косточкам индексные файлы сайтов. Мы доверяем только тем, которые учитывают все изменения в алгоритмах поисковых систем. А таких сервисов всего 2: Google Webmaster Tools и «Анализ robots.txt» от Яндекса. Покажем, как работать с каждым из них.

Google Webmaster Tools

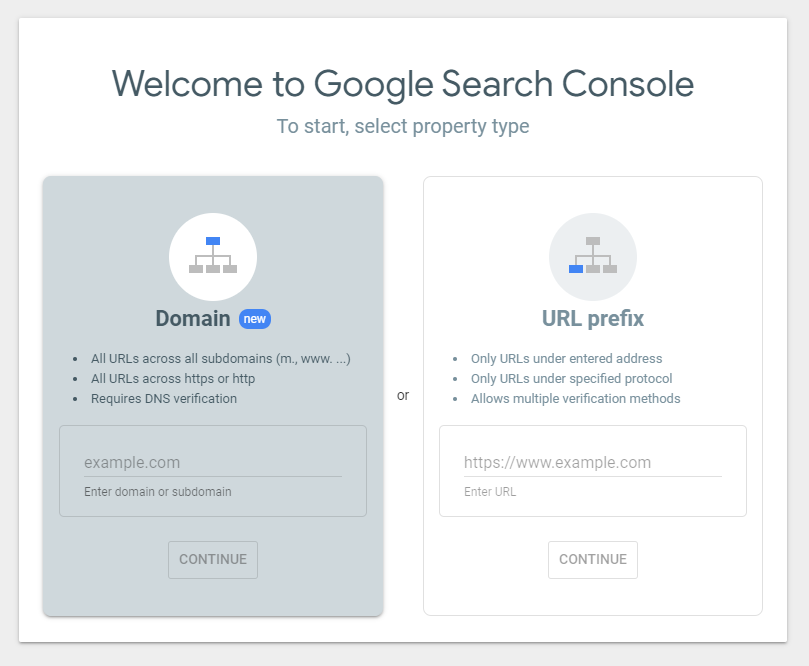

Чтобы начать пользоваться этим инструментом, нужно войти в свой Google-аккаунт, а потом открыть .

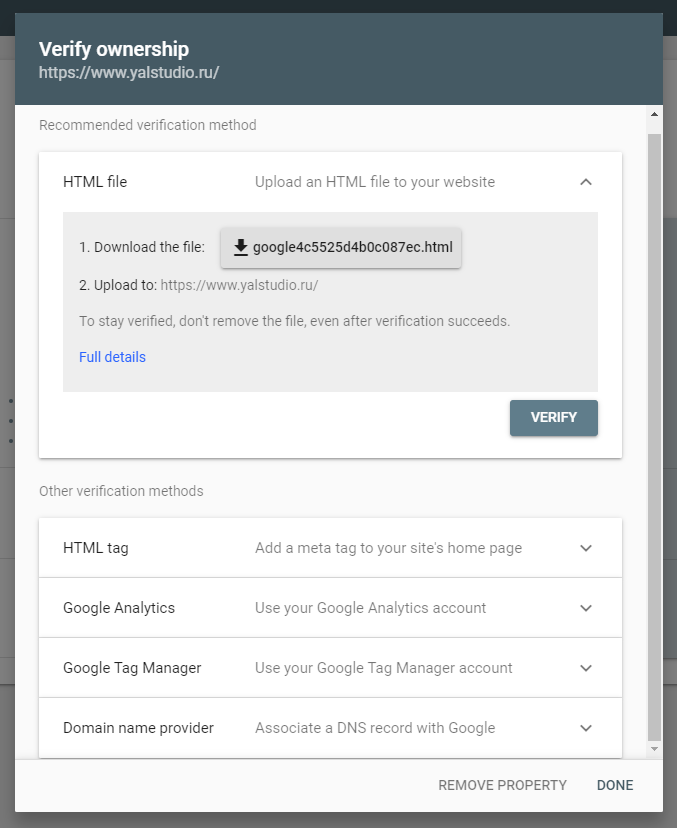

Если это ваше первое знакомство с Google Webmaster, придётся добавить сайт и подтвердить свои права на него. Сделать это можно несколькими способами. Самый простой из них – закачка файлов.

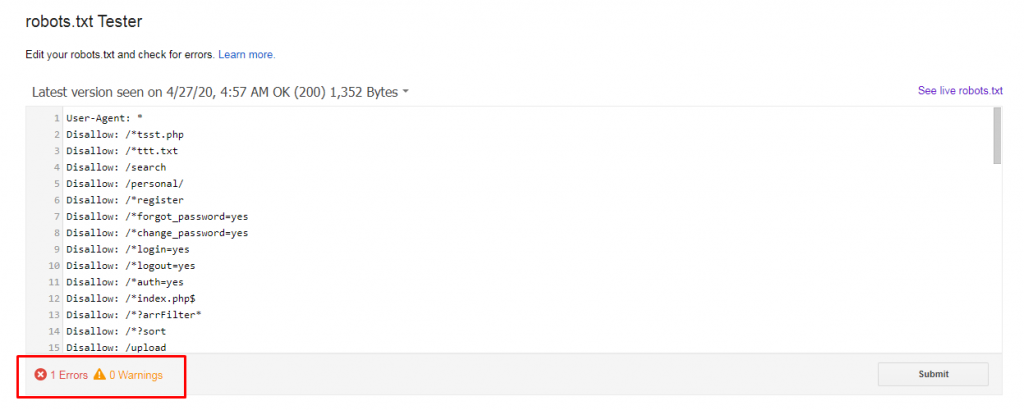

После подтверждения прав на сайт вы получите полный доступ к инструменту для проверки файла robots.txt. Выберите этот сервис в панели меню, затем укажите, что хотите проанализировать индексный файл своего сайта. И получите результаты проверки. Выглядеть это будет примерно так:

Красным прямоугольником мы выделили строку, на которую вам нужно обратить своё внимание в первую очередь. Здесь показывается, есть ли ошибки в robots.txt. Если инструмент нашёл ошибки, пролистайте содержимое файла с помощью бегунка и найдите значок белый крест в красном круге на полях. В тех строках, где есть такие значки, что-то написано неправильно. К сожалению, Google ещё не научился сразу же говорить, что именно не так, и предлагать исправления. Поэтому с ошибками придётся разбираться самостоятельно. Или обращаться за советом к профессионалам.

Новая версия этого инструмента для проверки файла robots.txt даёт возможность смотреть, открыты ли для индексации новые страницы. Она также позволяет вносить изменения в индексный файл сразу же после нахождения ошибок. Для этого больше не нужно открывать robots.txt в отдельной вкладке. Ещё одна фишка обновления – просмотр старых версий индексного файла. Вы можете посмотреть не только, что вы меняли в robots.txt, но и как на это реагировали роботы.

В связке с этим инструментом стоит использовать просмотр сайта глазами Googlebot. Применяя эту функцию, вы сможете проанализировать, понравится ли роботу поисковых систем ваш сайт или нет.

«Анализ robots.txt»

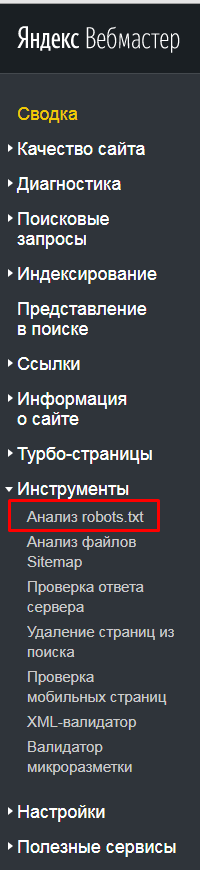

С этим сервисом всё проще, хотя бы потому что он приспособлен для русскоязычного пользователя. Прежде чем приступить к непосредственной работе с для проверки robots.txt, придется пройти те же этапы, что и с Google Webmaster Tools. Когда получите доступ к сервису, загляните в боковое меню и найдите в нём интересующий нас сервис.

На этой странице вы увидите результаты анализа индексного файла. Если в нём есть ошибки, их количество отобразится в нижней части страницы. В верхней части, где помещается robots.txt, можно будет подробно просмотреть ошибки и тут же исправить их.

В разделе «Анализ robots.txt» также можно узнать, индексируются ли определённые страницы сайта или нет. Для этого урлы вносят в нижнее окно и отправляют на проверку.

Какие ошибки часто возникают при работе с индексным файлом?

Правильная настройка robots.txt напрямую влияет на то, какие страницы сайта попадут в индекс и будут выводиться в поиске, а какие никогда там не окажутся. Поэтому так важно свести риск возникновения ошибок в работе индексного файла к минимуму. Вот самые частотные:- В файле прописано правило, закрывающее весь сайт от индексации, например, Disallow со значком слэш;

- Для индексации открыты страницы с ID-сессий и страницы с UTM-метками;

- Sitemap указан некорректно;

- Применяются только стандартные правила и не прорабатываются каталоги, страницы, технические папки и другие категории. Как результат, роботы индексируют всё подряд.

Не так просто, как кажется

Думали, что разберетесь с robots.txt за 5 минут и тут же внесете в него правки, но что-то пошло не так? Не расстраивайтесь. Специалисты Студии ЯЛ решат вашу проблему. Позвоните нам и мы дадим профессиональный совет. Ну а если вы не хотите разбираться с индексным файлом, поручите это нам. В рамках оптимизации и SEO-продвижения сотрудники Студии ЯЛ приведут в порядок ваш robots.txt и не только.

Другие материалы:

расчет стоимости проекта, а так же план его реализации.

Наши менеджеры уже изучают вашу заявку и свяжутся с вами

Наши менеджеры уже изучают вашу заявку и свяжутся с вамив самое ближайшее время

в рабочее время нашей компании.

партнером

Анализ robots.txt для чего вообще. Дайте примеры какие-нибудь.

Кому: Анна, да все просто. У вас могут быть бесполезные страницы или дубли в индексе. Их можно закрыть в robots. Можно запретить некоторых ботов. Кстати иногда получается так, что ошибочно закрываются полезные страницы. У нас самих был такой случай пару лет назад. Долго ждали индексации одной из статей и только через три недели увидели, что данная страница закрыта в robots по шаблону. Так что анализ очень нужен.