Удаляем вредные страницы с сайтов по методу Бретта Табке

Сегодня у нас на столе статья Бретта Табке. Как обычно перевели и дополнили ее для вас. Не забываем ознакомиться с нашей статьей: Удалять или лечить: . Напомним, что Бретт Табке, специалист в работе именно с Гуглом.

Итак, давайте разберемся, как на практике находить материалы, которые пора удалять.

Почему это важно? Большинство сайтов давно перестали понимать, как их воспринимают поисковые системы. Годы непрерывных публикаций, обновлений и реакций на алгоритмические изменения создали набор страниц, чья логика понятна только изнутри компании, но выглядит хаотичной для поисковиков.

Раньше, когда трафик был дешевым, а поисковая выдача — щедрой, это не создавало проблем. Слабые страницы успешно прятались за топовыми материалами. Дублирующий контент не просто терпели — его приветствовали, потому что казалось, что так мы лучше раскрываем тему для поисковиков. В 2026 году поисковики работают иначе: они сжимают информацию, выбирают лучшее и генерируют ответы. Всё “непонятное” превращается в балласт.

Сменим прицел

Итак, как вы догадались, это не про решения об удалении. Это про способность временно забыть всё, что вы знаете о своем сайте, и увидеть его таким, каким его видят поисковые системы. Звучит просто, но требует железной дисциплины и бесстрашия — данные будут противоречить вашим представлениям, которые складывались годами.

Ключевая установка первого этапа: вы аудируете не качество контента, а чёткость сигналов, которые посылает ваш сайт.

Только поняв реальную картину, можно переходить к решениям об исправлении, объединении или удалении страниц. Без этого шага чистка контента превращается в лотерею. С правильным аудитом — в обоснованную стратегию.

Фаза 1. Главные ментальные ловушки контентного аудита

Большинство аудитов проваливаются не из-за нехватки данных, а из-за неверной исходной позиции. Когда вы начинаете делить страницы на "хорошие", "плохие", "вечнозелёные" или "устаревшие" — вы уже защищаете прошлые решения вместо того, чтобы анализировать настоящее.

У современного аудита одна задача: показать реальность так, как её видят поисковые системы сегодня, а не так, как вы помните процесс создания этих страниц три года назад.

Предвзятость проявляется в трёх формах:

Ностальгия по трафику. Страницы, которые когда-то приносили визиты, получают пропуск на следующий этап, хотя спрос давно сместился в другое место.

Редакционная важность. Команды защищают контент, который кажется значимым для бизнеса, но фактически не приносит результатов.

Трафиковая слепота. Вы радуетесь позициям в выдаче, не проверив, приводят ли они хоть к одному клику.

Убираем эмоции: что нужно игнорировать

Если в процессе аудита вы ловите себя на этих мыслях — это сигнал вернуться к холодным данным:

- "Эта страница раньше отлично ранжировалась"

- "Эта тема стратегически важна для компании или редакции"

- "Но она же в топ-10 по ключевому слову!"

- "Сюда ведут обратные ссылки"

- "Мы потратили кучу денег на создание этого материала"

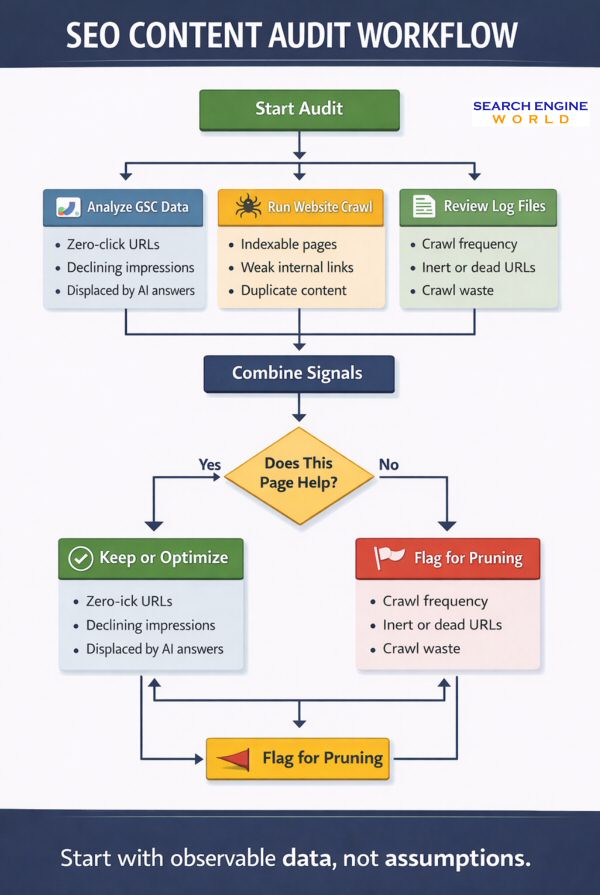

Методология: три источника данных

Правильный аудит начинается с сырых сигналов, а не оценочных суждений.

Google Search Console — ваши глаза

GSC показывает, как контент реально взаимодействует с поисковым спросом прямо сейчас.

Что делать: экспортируйте все URL с показами за последние 6-12 месяцев. Отдельно выделите страницы, которые имеют показы, но не получают кликов.

Эти страницы — не просто тихие неудачники. Они активно сигнализируют о проблемах: несоответствии контента запросу, конкуренции с другими вашими же страницами или вытеснении ИИ-ответами в выдаче.

Типичное открытие: на зрелых сайтах 20-30% URL генерируют 90% осмысленного трафика. Остальное — шум.

Парсинг сайта — рентген структуры

Парсер показывает техническую архитектуру: какие URL индексируются, как настроены канонические адреса, на какой глубине перелинковки находятся страницы, где есть дублирование. Если у вас пять страниц отвечают на один вопрос, и ни одна не доминирует в выдаче — это проблема. Вы сами создали внутреннюю конкуренцию и запутали поисковики.

Логи сервера — робот не читает, а мы читаем

Краулер показывает, что существует. GSC показывает, что попадает в выдачу. Логи показывают, что поисковые роботы реально загружают.

Страницы, которые постоянно сканируются ботами, но не получают ни показов, ни кликов — это не нейтральный балласт. Они жрут краулинговый бюджет и размывают релевантность сайта, не давая ничего взамен.

Противоположная ситуация тоже информативна: страницы, которые редко сканируются, но генерируют показы, обычно указывают не на слабость контента, а на провалы внутренней перелинковки.

Классифицируйте

На первом этапе главное — удержаться от немедленных действий. Это этап классификации, а не экзекуции.

Маркируйте страницы строго по наблюдаемому поведению:

- Показы есть, кликов нет

- Показы падают несколько месяцев подряд

- Пересекается с другими страницами по интенту

- Уже вытеснена ИИ-обзорами в поисковой выдаче

- Активно сканируется, но не приносит результатов

Если в конце этого этапа вы чувствуете дискомфорт — отлично. Значит аудит работает, и вы действительно смотрите на реальность, а не на привычную картинку.

Что в сухом остатке?

Правильно проведённый аудит даёт чёткие артефакты. Если чего-то из этого списка нет — возвращайтесь к началу:

Полная инвентаризация URL с метками только по фактическому поведению (без оценок типа "качественный" или "важный")

- Список страниц с показами без кликов за 6-12 месяцев

- Выявленные кластеры конкурирующих страниц — где несколько URL борются за один запрос или сущность

- Список URL с высокой краулинговой нагрузкой, но нулевой отдачей

Непредвзятый аудит не отвечает на вопрос "что удалить". Он показывает, где ваш сайт посылает противоречивые сигналы поисковикам. И это фундамент для всех следующих решений.

Фаза 2: Сортировка

Вторая фаза — критический момент, где большинство контент-аудитов теряют системность. Именно здесь команды возвращаются к привычным метрикам и начинают защищать страницы, которые выглядят успешными сами по себе. В 2026 году неэффективность определяется не тем, на какой позиции находится страница, а тем, как она ведет себя после попадания в выдачу. Страницы могут ранжироваться, получать показы и при этом систематически не оправдывать своё существование с точки зрения вовлечённости, ясности посыла и конкуренции внутри самого сайта.

Методология сортировки

Сортировка заменяет наитие категоризацией. Страницы больше не оцениваются как "хорошие" или "плохие" — их анализируют по сигналам, которые они генерируют. Одни терпят неудачу из-за устаревания. Другие — из-за избыточности. Третьи — из-за неполноты, размытого фокуса или подавления более сильными внутренними соседями.

Улучшить. Страницы с признаками спроса, но недостаточной ясностью, глубиной или соответствием запросу.

Объединить. Множественные URL, конкурирующие за один и тот же объект, вопрос или задачу пользователя.

Удалить. Страницы без измеримого спроса, создающие шум в краулинге или релевантности.

Результат второй фазы — не исполнение решений, а устранение неопределённости. Каждый URL должен попасть в предварительную категорию, подкреплённую наблюдаемым поведением, а не мнениями.

Итоги фазы 2

По завершении сортировки каждый индексируемый URL должен иметь обоснованный предварительный вердикт:

- Страницы, отмеченные для улучшения из-за неудовлетворённого спроса или слабой вовлечённости

- Группы для консолидации на основе пересекающихся интентов

- Страницы для удаления из-за нулевого спроса или системной избыточности

Взгляд практика: почему это работает

За двадцать лет в SEO я видел сотни контентных стратегий. Эпоха "чем больше страниц, тем лучше" действительно закончилась, когда массово запустились ИИ-ответы в поисковой выдаче.

Сейчас ваши страницы конкурируют не друг с другом, а с синтезированным ответом, который вообще не требует перехода на сайт. Поисковики перешли от количественной к качественной оценке. Им нужны чёткие, непротиворечивые сигналы.

Методология из статьи полностью соответствует реалиям 2025 года. Мы используем похожий подход на клиентских проектах: GSC для понимания спроса, краулеры для технической архитектуры, логи для приоритетов роботов.

Главная сложность — не техническая, а психологическая. Убедить клиента удалить страницы, в которые когда-то вложили бюджет и время, — это отдельное искусство. Но цифры не врут: после правильной чистки трафик не падает. Он концентрируется на сильных страницах и растёт.

Фаза 3: Готовимся к ИИ-обзорам

Третья фаза переворачивает традиционное понимание текстовой оптимизации. Здесь аргументация в пользу чистки контента перестает крутиться вокруг позиций в выдаче и начинает фокусироваться на извлекаемости информации. Современные ИИ-системы работают принципиально иначе, чем классическая поисковая выдача. Они не награждают за "много страниц". Они выбирают самый чистый, наиболее однозначный источник, когда нужно быстро собрать ответ. Если ваш сайт предлагает пять пересекающихся ответов на один запрос, вы фактически усложняете поиск ваших материалов в сети.

Именно поэтому оптимизация контента важна даже когда клика не происходит вообще. Когда ИИ формирует ответ, модель обычно берет информацию из небольшого набора источников. Ваша задача — сделать так, чтобы эти системы выбирали именно вас: меньше конкурирующих URL, четче сигналы сущностей, одна страница, которая действительно закрывает вопрос полностью.

Если цель не в клике, то в чем? В видимости. Цитировании. В том, чтобы стать источником, который выживает после компрессии информации.

Как "чистые библиотеки контента" помогают ИИ извлекать информацию

Давайте поговорим о практических вещах:

Вероятность цитирования: одну определяющую страницу гораздо проще процитировать, чем пять почти дублей.

Распознавание сущностей: консолидированное покрытие темы снижает неоднозначность того, что представляет страница и сайт в целом.

Завершенность ответа: страницы, которые полностью решают задачу пользователя, попадают в резюме чаще, чем фрагментарные материалы.

Уверенность в извлечении: меньше внутренних противоречий означает меньше причин выбрать конкурента.

Итоги фазы 4

Четвертая фаза завершена, когда вы можете измерить "видимость без кликов" и встроить все в процесс, вам потребуется:

- Список целевых текстовых-кластеров, где вам нужна единственная цитируемая страница-победитель

- Определенные KPI без кликов (доля показов, цитирования, упоминания бренда, консолидация запросов)

- Доказательство снижения неоднозначности (меньше конкурирующих URL на набор запросов)

- Мониторинга изменений видимости после волн изменений

Какие факторы реально увеличивают видимость под ИИ

Сфокусируемся на сигналах, на которые ИИ-системы регулярно опираются при выборе источников. Никаких уловок, только известные факторы.

Сигналы свежести и актуальности

ИИ-системы предпочитают недавно обновленный материал при составлении своих ответов.

- Регулярные обновления избранных страниц

- Обновленные даты там, там где это уместно

- Актуальная информация (свежая статистика, исследования, данные).

Страницы, к которым не притрагиваются годами, с гораздо меньшей вероятностью будут использованы. Свежесть помогает системам доверять, что ответ по-прежнему актуален.

E-E-A-T и сигналы доверия

Выбор цитирований тесно отслеживает видимый опыт и авторитетность.- Четкие авторские подписи желательно со ссылками на страницы авторов

- Названные источники и ссылки

- Оригинальные данные или личный опыт

- Фактические данные там, где применимо

Консолидация данных без сигналов доверия оставляет системы в догадках. А догадки обычно отправляют их к другим данным, возможно предоставленных вашими конкурентами.

Структурированные данные и разметка

Форматирование делает страницы проще для обобщения и использования в ответах ИИ

- Schema разметка для статей

- FAQ где уместно

- Короткие вводные текстовые секции (о главном в этом тексте или блоки ссылок с якорями на разделы текста)

- Маркеры, таблицы и четкие разделы

Системы предпочитают контент, который быстро решает задачи. Простые текстовые кирпичи ее не устраивают.

Мониторинг за пределами классических позиций

Видимость без кликов все равно оставляет измеримые сигналы.

- Отслеживание цитирований ИИ

- Мониторинг упоминаний бренда

- Тренды консолидации запросов в разных сферах, нишах и запросах

Инструменты вроде Semrush AI Visibility и Ahrefs Brand Radar помогают выявить паттерны цитирований и упоминаний, которые никогда не появляются в отчетах по трафику или в отчетах по позициям.

Фаза 3 — это не погоня за ИИ-трендом. Это признание того, что извлечение информации меняется, и адаптация архитектуры сайта так, чтобы вы все еще могли выигрывать, даже когда пользователи не попадают на вашу страницу.

Как измерить успех проекта?

Здесь большинство инициатив по чистке контента тихо сливаются — не потому что работа была неправильной, а потому что табло с результатами так и не изменилось. Команды продолжали гнаться за базовыми метриками: трафиком, позициями и сессиями

Реальность измерений: если вы считаете только клики, вы систематически недооцениваете страницы, делающие больше всего работы.

Современный поиск и ИИ выявили новую проблему. Контент может быть успешным без получения кликов. Страницы могут формировать ответы, влиять на решения и появляться в резюме, пока графики трафика остаются на нуле. Измерения должны эволюционировать, иначе чистка всегда будет выглядеть как потеря.

Как это может выглядеть?

Эти сигналы неточны, но вместе они показывают, становится ли ваш сайт проще для понимания поисковиками..

Здоровье индекса: растущее соотношение проиндексированных страниц к отправленным, с меньшим количеством необъяснимых исключений или "просканировано, не проиндексировано"..

Концентрация показов: показы концентрируются на меньшем количестве URL вместо тонкого распределения по низкоценным страницам, которые никогда не конвертируют.

Консолидация запросов: множество запросов схлопываются на одну страницу

Видимость без визитов: контент появляется в резюме, цитированиях или упомянутых ответах.

Связь проведенных работ с "нулевыми кликами" с ROI

Если вы не можете связать видимость без кликов с деньгами, измерения снова свалятся в разговоры о трафике. Используйте следующие наработки.

- Фиксируйте лиды именно на лучших страницах выбранных вами

- Ассоциированные конверсии

- Рост брендового поиска: запросы "бренд плюс тема"

- Обратная связь при продажах: какие страницы упоминают потенциальные клиенты на созвонах

Как измерять концентрацию показов на "правильных" страницах

Вам не нужен навороченный инструмент для этого. Цель — доказать, что спрос схлопывается на меньшее количество более сильных страниц.

Доля показов топ-10 URL: (показы от топ-10 URL) разделить на (общие показы)

Доля показов топ-20 URL: та же идея, больший набор для крупных сайтов

Количество конкурирующих URL на кластер: сколько URL все еще получают показы для одного набора запросов

Если топовые URL удерживают большую долю после чистки — консолидация работает. Если доля падает или распределяется — вы создали новую неоднозначность.

Не измеряйте это как раньше: средняя позиция по сайту, общее количество проиндексированных страниц как метрика для хвастовства и сырые итоговые данные по сессиям будут врать вам во время консолидации.

Самопроверка перед тем как сдавать проект

Ловим несоответствия которые могут вас смутить или повредить проекту:

- Лучшая страница закрыта от индексации

- Внутренние ссылки все еще указывают на редиректные страницы

- Несоответствие canonical: canonical указывает не на лучшую страницу, либо конфликтует с картой сайта

- Проблемы с Schema: разметка удалена во время слияний или изменений шаблона, мелкие проблемы

- Много посадочных страниц по один набор поисковых запросов

Реалистичный пример

Вот так может выглядеть успех "большой зачистки" и он редко проявляется как всплеск трафика.

- Изменение: почистили около 40% пересекающихся постов.

- Чистка: перестроили внутренние ссылки и выровняли каноникалы и карты сайта для продвижения базовых страниц.

- Результат: доля показов основного URL выросла примерно на 20%, так как спрос схлопнулся на меньшее количество страниц.

- Бизнес-эффект: объем лидов остался плоским сначала, затем улучшился после ежеквартальных обновлений страниц более четких сигналов доверия

Итоги фазы 4

Проект завершен, когда вы сможете защитить результат, не указывая только на трафик, а можете показать дополнительные сигналы.

- Доказательства консолидации запросов к меньшему количеству более сильных URL

- Определенный набор KPI без кликов, отслеживаемый с повторяемой периодичностью

- Тренд концентрации показов (доля топ-10 или топ-20), показывающий схлопывание спроса на основных страницах

- Рост лидов с основных страниц

- Отсутствие технических ошибок связанных с удаленными страницами

Финальная проверка: доказывайте пользу чистки реальными параметрами иначе вы попадете впросак.

Заключение

Чистка контента идет против инстинктов, которые построили большинство крупных сайтов. Публикация нового контента видится продуктивной. Удаление казалось разрушительным. В 2026 году это понимание перевернуто.

Поисковые системы награждают четкость, а не охват. ИИ-системы награждают завершенность, а не изобилие. Большие контентные сайты, которые никогда не обновляются, дрейфуют в неоднозначность, а неоднозначность — это то, что современные системы извлечения обходят стороной.

Чистка — это не про удаление вашей истории. Это признание того, что информация стареет, спрос смещается, и системы меняются. Сайты, которые адаптируются — это не те, кто публикует больше всего, а те, кто тяжелее всего работает над текущей историей.

Студия ЯЛ: два десятилетия digital-экспертизы в Новосибирске

Двадцать лет на рынке интернет-маркетинга — это не просто стаж. Это путь новосибирской команды от первых кампаний в контекстной рекламе до полноценного продвижения медиапроектов в эпоху ИИ.

Наша специализация — новостные порталы и СМИ. Пока конкуренты фокусируются на интернет-магазинах, мы работаем с тем, что освоили до мелочей: выводим региональные и федеральные издания к их читателям в условиях беспощадной борьбы за трафик.

Сегмент СМИ выбран неслучайно. Это самая требовательная ниша, где шаблоны не работают. Поисковые алгоритмы обновляются каждый месяц, пользователи меняют привычки, борьба за высокие позиции идет на пределе возможностей. Освоил продвижение новостного сайта — остальное покажется простым.

Мы работаем с контекстной рекламой в Новосибирске и SEO-оптимизацией. Никаких обещаний мгновенных результатов и гарантий топ-1. Вместо этого — проверенные методы, аналитический подход и готовность адаптироваться под новые реалии рынка.

Два десятилетия опыта научили нас замечать неочевидное: как избыточные теги разрушают индексацию, почему нерабочие внешние ссылки пожирают краулинговый бюджет, какую роль играют авторские теги и как превратить старые публикации в источник актуального трафика.

Мы не гонимся за массовостью. Студия ЯЛ — это узкая команда профессионалов, работающая с проектами избирательно. Нас привлекают задачи, требующие глубокой экспертизы, а не потоковое производство стандартных услуг.

За двадцать лет вырабатывается способность видеть системные паттерны в кажущемся беспорядке. Понимание, какие тренды реально работают, а какие — лишь шум. И умение говорить заказчику правду о том, что реально достижимо, а что — маркетинговая иллюзия.

Наши менеджеры уже изучают вашу заявку и свяжутся с вами

Наши менеджеры уже изучают вашу заявку и свяжутся с вами