Страница просканирована, но пока не проиндексирована для сайтов СМИ

Статус "Страница просканирована, но пока не проиндексирована" в Google Search Console указывает на то, что поисковая система выявила URL-адрес, но пока не выполнила его сканирование и индексацию. Это не является окончательным решением, поскольку, согласно официальной документации, Google может вернуться к этой странице позднее без каких-либо дополнительных действий с вашей стороны.

Однако скорее всего существуют факторы, препятствующие полноценной обработке страницы:

- Серверные и технические неполадки, ограничивающие возможности сканирования

- Проблемы, связанные с качеством самой страницы или сайта в целом

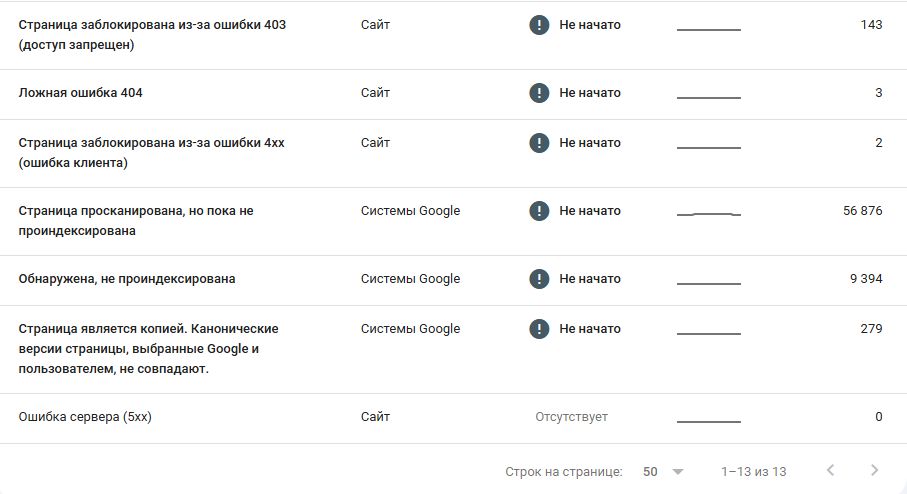

В отношении сайтов СМИ под данный статус могут попадать десятки тысяч страниц на сайте. Возникает вопрос, что с этим делать?

Решения проблемы

Самое простое и показательное, выполнить индексации через Search Console.

Данный метод часто помогает устранить проблему, особенно когда Google медленно обрабатывает новые URL-адреса (встает вопрос из-за чего). После запроса индексации возможны и негативные сценарии:

- URL получает статус "Просканировано — в настоящее время не проиндексировано"

- Происходит временная индексация

- Ничего не происходит

Все варианты свидетельствуют о наличии глубоких проблем. Второй сценарий возникает потому, что запрос индексации временно повышает "свежесть" URL, что может позволить странице преодолеть необходимый порог качества страницы или домена в целом.

Аспекты качества страницы

Возникает логичный вопрос: как Google оценивает качество непроиндексированной страницы? Ответ заключается в том, что система оценивает качество на основе анализа других страниц того же домена. Классификация также базируется на архитектуре сайта и шаблонах URL.

Таким образом, перемещение страниц из "списка ожидания" в очередь сканирования может откладываться из-за низкого качества аналогичных страниц. Возможно, материалы со схожими URL или из похожих разделов сайта демонстрируют недостаточную ценность по сравнению с конкурирующим контентом.

Потенциальные проблемы включают:

- Недостаточную глубину содержания

- Низкое качество окружающего контента

- Отсутствие уникальности представленной информации

- Манипулятивные практики (автоматически сгенерированный, переработанный или дублирующийся контент)

Повышение качества контента в тематическом кластере сайта может положительно повлиять на интерес Google к более целенаправленному сканированию. Также полезно исключить из индексации низкокачественные страницы для улучшения общего соотношения качественных и некачественных материалов.

Бюджет сканирования и эффективность

Бюджет сканирования часто неправильно интерпретируется. По официальному заявлению представителя Google Гэри Илиеса, около 90% веб-сайтов не нуждаются в контроле бюджета сканирования — эта проблема актуальна преимущественно для корпоративных ресурсов.

Эффективность сканирования, напротив, влияет на сайты любого масштаба. Если ваш сайт:

- Дублирует URL-адреса с параметрами

- Допускает использование версий с конечной косой чертой и без неё

- Доступен по HTTP и HTTPS протоколам

- Представлен на нескольких поддоменах (website.com и www.website.com)

В таких случаях могут возникать проблемы с дублированием, влияющие на приоритеты сканирования. Вы потенциально расходуете бюджет сканирования на избыточные URL и запросы.

Учитывая поэтапное сканирование сайтов Googlebot, ресурсы системы могут оказаться недостаточными для оперативного обнаружения новых URL.

Рекомендуется регулярно проверять:

- Корректность перенаправления страниц на единый поддомен

- Использование одного HTTP-протокола

- Отсутствие ненужных перенаправлений во внутренних ссылках

- Для сайтов с параметрами (например, фильтрами товаров в e-commerce) целесообразно ограничить сканирование определенных путей через файл robots.txt.

Производительность сервера также влияет на распределение бюджета сканирования. Перегруженный и медленный сервер может создавать проблемы с индексацией, вынуждая Googlebot отложить обработку контента.

Взаимосвязь сканирования и индексации

Исследования показывают количественную взаимосвязь между этими процессами. URL-адреса имеют тенденцию выпадать из индекса, если их не сканируют хотя бы раз в 75-140 дней. Вариативность этого периода зависит от популярности и востребованности конкретного адреса.

Новые отраслевые данные определяют "130 дней" как эталонный показатель, что соответствует многолетним наблюдениям в этой области.

Значение внутренней перелинковки

Google уделяет меньше внимания URL-адресам с недостаточным количеством внутренних ссылок, иногда полностью исключая их из индекса.

Для оценки внутренних ссылок можно использовать инструменты вроде Screaming Frog или Sitebulb. Продвижение новостного сайта требует логичной структуры с продуманной системой внутренних ссылок.

При наличии проблем с внутренней перелинковкой полезно применить HTML-карты сайта. Несмотря на то, что они считаются устаревшими, они всё еще эффективны для обеспечения связности страниц..

Для сайтов с большим количеством URL рекомендуется разделять их на несколько страниц, а не размещать на одной..

При использовании Jamstack или JavaScript-фреймворков следует убедиться, что внутренние ссылки представлены корректно.

Студия ЯЛ: двадцать лет создания сайтов в Новосибирске

Два десятилетия в создании сайтов Новосибирск — история новосибирской команды, которая эволюционировала от простых корпоративных проектов до технически сложных новостных платформ и медийных порталов на WordPress.

Наша специализация — сайты для СМИ и информационных изданий. Пока другие студии множат типовые лендинги, мы сосредоточены на том, что освоили досконально: разрабатываем и восстанавливаем новостные ресурсы для региональных и общероссийских медиа, способные справляться с серьезными нагрузками и функционировать десятилетиями.

Выбор медийного сегмента не случаен. Это наиболее сложная техническая ниша. Здесь недостаточно визуальной привлекательности — требуется продуманная структура для ежедневной публикации сотен материалов, корректная организация контента для поисковиков, высокая скорость отклика при массовом наплыве посетителей и понятный интерфейс управления для редакционной команды. Освоил новостной портал — с остальным справишься играючи.

Главный инструментарий — WordPress и Битрикс, с которым мы работаем свыше двадцати лет. Не даём обещаний о мгновенном запуске. Но когда беремся за миграцию устаревшего ресурса или создание свежего проекта — реализуем быстро, профессионально и с глубоким пониманием нюансов медийной индустрии.

За два десятка лет научились различать существенное: как организовать кеширование для многотысячных массивов страниц, почему принципиальна точная синхронизация дат при переносе контента, зачем применять отложенную подгрузку визуального контента и как предотвратить сбои при переходе на новые версии серверного ПО.

Студия ЯЛ — специализированный коллектив сотрудников, тщательно выбирающий особенные заказы. Нас интересуют непростые технические вызовы: возвращение к жизни заброшенных платформ, спасение объемных архивов, ускорение перегруженных систем — не поточное тиражирование шаблонных сайтов.

Двадцатилетний путь в разработке показывает: незначительных деталей не существует. Каждая строка программного кода, подключенный компонент, выбранная архитектурная концепция влияют на срок жизни проекта.

Наши менеджеры уже изучают вашу заявку и свяжутся с вами

Наши менеджеры уже изучают вашу заявку и свяжутся с вами